تحية طيبة لكم جميعاً

موضوع سوزان الاخير حول فريق تقنية من اجل السلام وتحليله للصوتيات المسربة للسيد المالكي

كان هناك مقال تقني كتبته لاحدى المجلات التقنية IT Ambition قبل اكثر من عام حول تقنية التزييف العميق وامكانية

تغيير الكلام وبسهولة كبيرة من خلال برامج خاصة.

ربما الكثير يستغرب من الموضوع لكن اصحاب الاختصاص والمهتم بالتقنية والتكنلوجيا ليس لديه اي غرابة في الموضوع

وهناك دلائل سوف ترونها في المقال:

أليكم نص المقال

مستقبل التكنلوجيا يثير رعباً وهلعاً في العالم... تقنية التزييف العميق أنموذجاً

--------------------------------------------------------

يشهد العالم تطوراً ملحوظاً لعلم التقنية والتكنلوجيا على الرغم من المشاكل الاقتصادية والسياسية وتفشي الاوبئة والامراض التي تعصف العالم بين حين وأخر ولكن قد يكون هذا التطور سلباً لا ايجاباً من خلال الممارسات واستخدام التطبيقات بشكل يزيف الحقائق مما اثار قلقاُ حول المستوى الذي وصلت اليه التكنلوجيا .

ومن التطورات الحديثة للتكنلوجيا التي جعلت العالم يعيش برعب وهلع بعدما ظهرت تقنية جديدة تزيف الحقائق من خلال تغيير خوارزميات معينة عن طريق المبرمجيين بواسطة برامج تعمل على الحاسب الالي وهذه تقنية تسمى بتقنية التزييف العميق (Deep Fake).

ماهي تقنية التزييف ( Deep Fake):

هي تقنية تقوم على صنعِ فيديوهات مزيّفة عبر برامج الحاسوب من خلال تعلّم الذكاء الاصطناعي وبواسطة التعلم الالي او التعلم العميق (Machine Learning او Deep Learning) . تقومُ هذهِ التقنيّة على محاولة دمجِ عدد من الصور ومقاطع الفيديو لشخصيّة ما من أجلِ إنتاج مقطع فيديو جديد باستخدام تقنية التعلم الآلي قد يبدو للوهلة الأولى أنه حقيقي لكنّه في واقع الأمر مُزيّف.

تعتمد هذه التقنية على خوارزميات التعلم العميق (فئة من الذكاء الاصطناعي تهتم بالخوارزميات التي يمكن أن تتعلم وتصبح أكثر ذكاءً بمرور الوقت) لتزوير مقاطع الفيديو وتصبح وكأنها حقيقية ولايقع الزيف على الصورة فقط بل يتعدى ذلك حتى بأمكان هذه التقنية ان تزيف الصوت كذلك.

تقوم الشبكات العصبية عبر هذه التقنية بمسح مجموعات البيانات الكبيرة لمعرفة كيفية تكرار سلوكيات وصوت وتعبيرات وجه الشخص.

نمتْ هذه التقنية بشكل كبير جداً في السنوات القليلة الماضية إذ أشارت دراسة لشركة (Sentinel) التي تتخذ من إستونيا مقراً لها إلى نمو عدد مقاطع التزييف العميق على الإنترنت منذ عام 2019 وإلى يومنا من 14 ألفاً و678 مقطعاً إلى 145 ألفاً و277، واصفة النمو بنسبة 900% تقريباً بأنه "هائل".

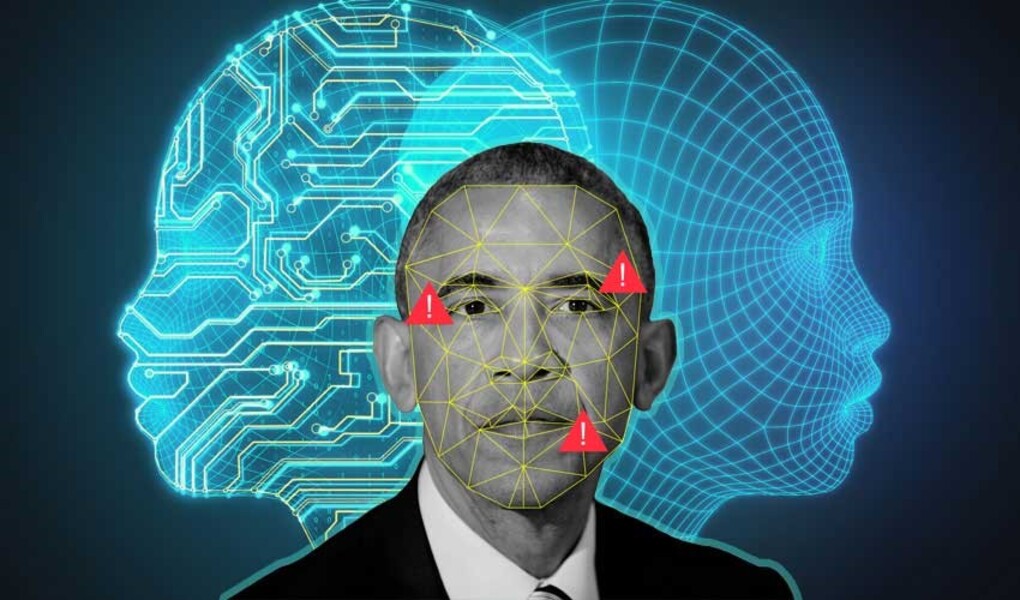

[IMG]file:///C:\Users\GLOBAL~1\AppData\Local\Temp\msohtmlclip1\ 01\clip_image002.jpg[/IMG]يعود تاريخ هذه التقنية الى أواخر التسعينات من القرن الماضي حتى بدأت الابحاث حول هذه التقنية في عام 1997 م ولكنها لم تعرف على نطاق واسع وظهرت بشكل جلي في عام 2017 م حيث نشر فيديو للرئيس الامريكي السابق (باراك اوباما) وانتشر بشكل واسع على مواقع التواصل الاجتماعي, وهو يتكلم عن المعلومة المزيفة ويحذر منها ويقول (انه يجب ان لا نثق بأي شيء موجود على الانترنت) ولكن تبين فيما بعد ان الفيديو نفسه مزيف وفي الحقيقة انه من كان يتكلم في هذا الفيديو هو الممثل والمخرج الامريكي الكوميدي (جوردان بيل) وليس الرئيس الامريكي (بارك اوباما) وبهذا تمكن بيل من تزييف حقيقة الكلام الذي لم يقوله الرئيس السابق للولايات المتحدة الامريكية.

وأيضاً تطورت في الاستخدام لهذه التقنية وانتشرت مقاطع فيديو إباحية يظهر فيها وجوه شخصيات سينمائية مشهورة بدلًا من الممثلين الحقيقيين، وأدى ذلك فيما بعد إلى انتشار خوارزميات وبرامج مفتوحة المصدر تسهّل استخدام هذه التقنية من قبل أي شخص.

وتعتمد أغلب طرق التزيف العميق على تقنية تسمى “شبكة الخصومة التوليدية(Generative Adversarial Networks) وتعرف اختصارًا (GANs)، حيث تستخدم خوارزميتين متنافستين للذكاء الاصطناعي الأولى تسمى المُمَيِّز أو المدقق (Discriminator) والأخرى تسمى المولِّد (Generator)، تعمل شبكة الخصومة التوليدية على إنشاء مجموعة من البيانات المفبركة من خلال المولِّد، ثم عرضها على المدقق بهدف تقوية قدراته على التفريق بين البيانات الحقيقية والمفبركة، بعد ذلك يتم تدريب المولِّد ذاته على تحسين إنتاج بيانات مفبركة من أجل خداع المدقق، وفي كل مرة يقوم المدقق بتحديد المحتوى على أنه ملفق، يتم تزويد المولِّد بمعلومات حول كيفية تحسين التزييف في المرة القادمة.

سلبيات وأيجابيات تقنية التزييف العميق (Deep Fake):

الاستخدام الخاطىء لهذه التقنية لتحقيق اغراض شخصية وسياسية يسبب الكثير من السلبيات لذلك من مخاطر هذه التقنية انها تقوم بتزييف الشخصيات المشهورة من خلال انتحال الشخصية وسرقة الاموال مثلاُ.

كذلك من مخاطر مستخدمي هذه التقنية انهم يقومون بأبتزاز شخصيات مشهورة من خلال انشاء فيديو اباحي وهذا ماحدث في بداية هذه التقنية عندما استخدم مستخدما يدعى نفسه (deepfakes) على موقع Reddit واخرون بدأوا بنشر مقاطع فيديو اباحية لفنانين مشاهير وتم تركيبها بفيديوهات مزيفة بواسطة تقنية التزييف العميق.

وفي عام 2018 احد مستخدمي موقع Reddit قام بنشر طريقة استخدام الشفرة والبرامج التي تحتاج اليها لكي تصنع مقاطع مزيفة والغرض منه هو صنع مقاطع اباحية مبركة للمشاهير, حتى قامت ادارة الموقع بحظر هذا المستخدم (deepfakes) لانه ينشر هذه المقاطع .

حتى انها تقوم هذه التقنية بخلق وجوة غير حقيقية وغير موجودة في العالم لانه تحوي العديد من القواعد البيانات من الوجوه فيمكنه ان يمزج بينها حيث هناك مواقع عدة تعتمد على هذه التقنية لأنشاء وجوة جديدة غير موجودة بالاصل ومن هذه المواقع هو موقع www.thispersondoesnotexist.com.

وأيضاً هناك من يستخدم هذه التقنية للتشويه السياسي للاطاحة بالسياسيين المنافسين في العالم وخصوصاً في الولايات المتحدة الامريكية من خلال صناعة فيديوهات مفبركة.

ولكن هناك جانب أيجابي في هذه التقنية حيث يتوقع الخبراء أن يتم استخدام أصواتنا في المستقبل بمساعدة أجهزة المساعديين الصوتيين مثل (أليكسا) من أمازون، للسماح للمستخدمين بالبقاء على اتصال مع أحبابهم بعد الوفاة.

كما يمكن محاكاة جوانب كاملة من شخصياتنا بعد الموت، وتدريبها بأصواتنا الموجودة على وسائل التواصل الاجتماعي.

ويمكن أيضاً أن يتم استخدامها في صناعة السينما؛ لكونها تساعد في تكوين أصوات رقمية للممثلين الذين فقدوا أصواتهم بسبب المرض، أو لتحديث لقطات الفيلم بدلاً من إعادة تصويرها.

وجاء في دراسة نُشرت في مجلة (مراجعة إدارة الابتكار التكنولوجي)، أن صانعي الأفلام سيتمكنون من إعادة إنشاء المشاهد الكلاسيكية في الأفلام، وإنشاء أفلام جديدة من بطولة ممثلين ماتوا منذ فترة طويلة.

ضياء المالكي

30- مارس - 2021

رد مع اقتباس

رد مع اقتباس