مراقبة

تاريخ التسجيل: January-2021

الدولة: العراق/بغداد

الجنس: أنثى

المشاركات: 15,517 المواضيع: 1,801

أكلتي المفضلة: الدولمة

موبايلي: A11

آخر نشاط: منذ يوم مضى

الذكاء الاصطناعي يجعل الحياة أسهل ، ولكن ما الذي سيخسره البشر في الصفقة؟

يعد الذكاء الاصطناعي بجعل الحياة أسهل ، ولكن ما الذي سيخسره البشر في الصفقة؟

الذكاء الاصطناعي يقتل الاختيار والفرص - مما يعني تغيير معنى أن تكون إنسانًا

25 فبراير 2021 ، 8.28 صباحًا بتوقيت شرق الولايات المتحدة

لطالما كان تاريخ استخدام البشر للتكنولوجيا تاريخًا للتطور المشترك. جادل الفلاسفة من روسو إلى هايدجر إلى كارل شميت بأن التكنولوجيا ليست أداة محايدة أبدًا لتحقيق الغايات البشرية. الابتكارات التكنولوجية - من الأكثر بدائية إلى الأكثر تعقيدًا - تعيد تشكيل الناس أثناء استخدامهم لهذه الابتكارات للتحكم في بيئتهم. الذكاء الاصطناعي هو أداة جديدة وقوية ، وهو أيضًا يغير البشرية.

أتاحت الكتابة والمطبعة لاحقًا تسجيل التاريخ بعناية ونشر المعرفة بسهولة ، لكنها قضت على تقاليد رواية القصص الشفوية التي تعود إلى قرون . لقد غيرت الكاميرات الرقمية والهاتفية المنتشرة في كل مكان كيف يشعر الناس بالأحداث ويتصورونها . تعني أنظمة GPS المتاحة على نطاق واسع أن السائقين نادرًا ما يضيعون ، لكن الاعتماد عليهم أضعف أيضًا قدرتهم الأصلية على توجيه أنفسهم .

الذكاء الاصطناعي لا يختلف. في حين أن مصطلح الذكاء الاصطناعي يستحضر القلق بشأن الروبوتات القاتلة أو البطالة أو حالة المراقبة الهائلة ، إلا أن هناك تداعيات أخرى أعمق. بينما يشكل الذكاء الاصطناعي بشكل متزايد التجربة البشرية ، كيف يغير هذا ما يعنيه أن تكون إنسانًا؟ محور المشكلة هو قدرة الشخص على اتخاذ الخيارات ، وخاصة الأحكام التي لها آثار أخلاقية.

الاستيلاء على حياتنا؟

يتم استخدام الذكاء الاصطناعي لأغراض واسعة وسريعة التوسع. يتم استخدامه للتنبؤ بالبرامج التلفزيونية أو الأفلام التي سيرغب الأفراد في مشاهدتها بناءً على التفضيلات السابقة ولاتخاذ قرارات بشأن من يمكنه اقتراض الأموال بناءً على الأداء السابق والوكلاء الآخرين لاحتمال السداد. يتم استخدامه ل كشف المعاملات التجارية الاحتيالية و تحديد الأورام الخبيثة . يتم استخدامه لقرارات التوظيف وإطلاق النار في المتاجر الكبيرة ومناطق المدارس العامة . ويتم استخدامه في تطبيق القانون - من تقييم فرص العودة إلى الإجرام ، إلى تخصيص قوات الشرطة ، إلىالتعرف على الوجه للمشتبه فيهم جنائياً .

تجلب لك المحادثة تحليلات من العلماء والأطباء.

يتعلم أكثر

يمثل العديد من هذه التطبيقات مخاطر واضحة نسبيًا. إذا تم تدريب الخوارزميات المستخدمة للموافقة على القرض والتعرف على الوجه والتوظيف على بيانات متحيزة ، وبالتالي بناء نماذج متحيزة ، فإنها تميل إلى إدامة التحيزات وعدم المساواة القائمة . لكن يعتقد الباحثون أن البيانات المنظَّفة والنمذجة الأكثر صرامة من شأنه أن يقلل ويحتمل أن يقضي على التحيز الخوارزمي . حتى أنه من الممكن أن يقوم الذكاء الاصطناعي بعمل تنبؤات أكثر عدلاً وأقل تحيزًا من تلك التي يقوم بها البشر.

عندما يكون التحيز الخوارزمي مشكلة تقنية يمكن حلها ، على الأقل من الناحية النظرية ، فإن السؤال عن كيفية تغيير الذكاء الاصطناعي للقدرات التي تحدد هوية البشر هو أكثر جوهرية. لقد كنا ندرس هذا السؤال خلال السنوات القليلة الماضية كجزء من مشروع الذكاء الاصطناعي والخبرة في مركز الأخلاقيات التطبيقية في UMass Boston .

فقدان القدرة على الاختيار

جادل أرسطو بأن القدرة على إصدار أحكام عملية تعتمد على إصدارها بانتظام - على العادة والممارسة. نرى ظهور الآلات كقضاة بديلين في مجموعة متنوعة من سياقات العمل اليومية كتهديد محتمل للأشخاص الذين يتعلمون كيفية ممارسة الحكم بأنفسهم بشكل فعال.

في مكان العمل ، يتخذ المديرون بشكل روتيني قرارات بشأن من سيتم تعيينهم أو فصلهم من العمل ، وأي قرض للموافقة عليه ومكان إرسال ضباط الشرطة ، على سبيل المثال لا الحصر. هذه هي المجالات التي تحل فيها الوصفات الخوارزمية محل الحكم البشري ، وبالتالي فإن الأشخاص الذين ربما أتيحت لهم الفرصة لتطوير حكم عملي في هذه المجالات لن يعودوا كذلك.

قد تعمل محركات التوصية ، التي أصبحت وسطاء سائدًا بشكل متزايد في استهلاك الناس للثقافة ، على تقييد الاختيار وتقليل الصدفة. من خلال تزويد المستهلكين بخيارات منظمة خوارزميًا لما يجب مشاهدته وقراءته وتدفقه وزيارته بعد ذلك ، تستبدل الشركات الذوق البشري بذوق الآلة. من ناحية ، هذا مفيد. بعد كل شيء ، يمكن للآلات مسح مجموعة واسعة من الخيارات أكثر من أي فرد يحتمل أن يكون لديه الوقت أو الطاقة للقيام به بمفرده.

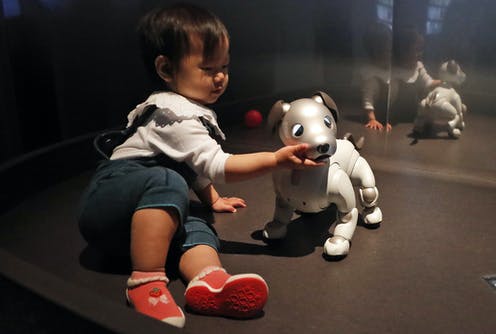

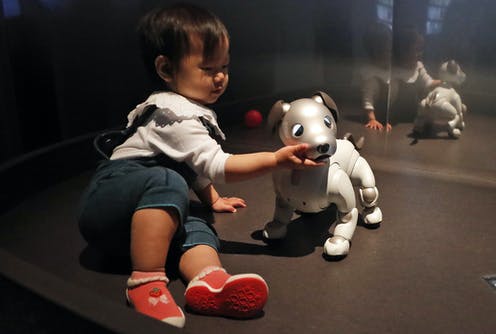

تقلل الخدمات التي تقدم توصيات بناءً على التفضيلات ، مثل الأفلام التي يجب مشاهدتها ، اكتشافات الصدفة. AP Photo / جيني كين

في الوقت نفسه ، على الرغم من ذلك ، يعمل هذا التنظيم على تحسين ما يفضله الأشخاص على الأرجح بناءً على ما يفضلونه في الماضي. نعتقد أن هناك بعض المخاطر المتمثلة في تقييد خيارات الأشخاص بماضيهم بطريقة جديدة وغير متوقعة - تعميم لـ "غرفة الصدى" الذي يراه الناس بالفعل على وسائل التواصل الاجتماعي.

يبدو أن ظهور التقنيات التنبؤية القوية قد يؤثر على المؤسسات السياسية الأساسية أيضًا. فكرة حقوق الإنسان ، على سبيل المثال ، ترتكز على البصيرة القائلة بأن البشر هم وكلاء مهيبون ، لا يمكن التنبؤ بهم ، يتمتعون بالحكم الذاتي ويجب أن تضمن الدولة حرياتهم. إذا أصبحت الإنسانية - أو على الأقل عملية صنع القرار فيها - أكثر قابلية للتنبؤ ، فهل ستستمر المؤسسات السياسية في حماية حقوق الإنسان بنفس الطريقة؟

متوقعة تماما

نظرًا لأن خوارزميات التعلم الآلي ، وهي شكل شائع من الذكاء الاصطناعي "الضيق" أو "الضعيف" ، تتحسن ، وبينما تتدرب على مجموعات بيانات أكثر شمولاً ، فمن المرجح أن تصبح أجزاء أكبر من الحياة اليومية قابلة للتنبؤ تمامًا. ستتحسن التوقعات بشكل أفضل ، وستجعل التجارب المشتركة في النهاية أكثر كفاءة وأكثر متعة.

يمكن للخوارزميات قريبًا - إذا لم تكن كذلك بالفعل - أن يكون لديها فكرة أفضل عن العرض الذي ترغب في مشاهدته بعد ذلك والمرشح الوظيفي الذي يجب عليك تعيينه أكثر منك. في يوم من الأيام ، قد يجد البشر طريقة يمكن للآلات أن تتخذ بها هذه القرارات دون بعض التحيزات التي يظهرها البشر عادةً.

ولكن إلى الحد الذي يجعل عدم القدرة على التنبؤ جزءًا من كيفية فهم الناس لأنفسهم وجزءًا مما يحبه الناس في أنفسهم ، فإن الإنسانية في طور فقدان شيء مهم. عندما تصبح أكثر وأكثر قابلية للتنبؤ بها ، فإن المخلوقات التي تعيش في العالم الذي يتوسط فيه الذكاء الاصطناعي بشكل متزايد ستصبح أقل شبهاً بنا.

رد مع اقتباس

رد مع اقتباس